Bonjour

je dois calibrer un signal de débitmètre sorte que le débit obtenu aient une erreur de 1% maximum.

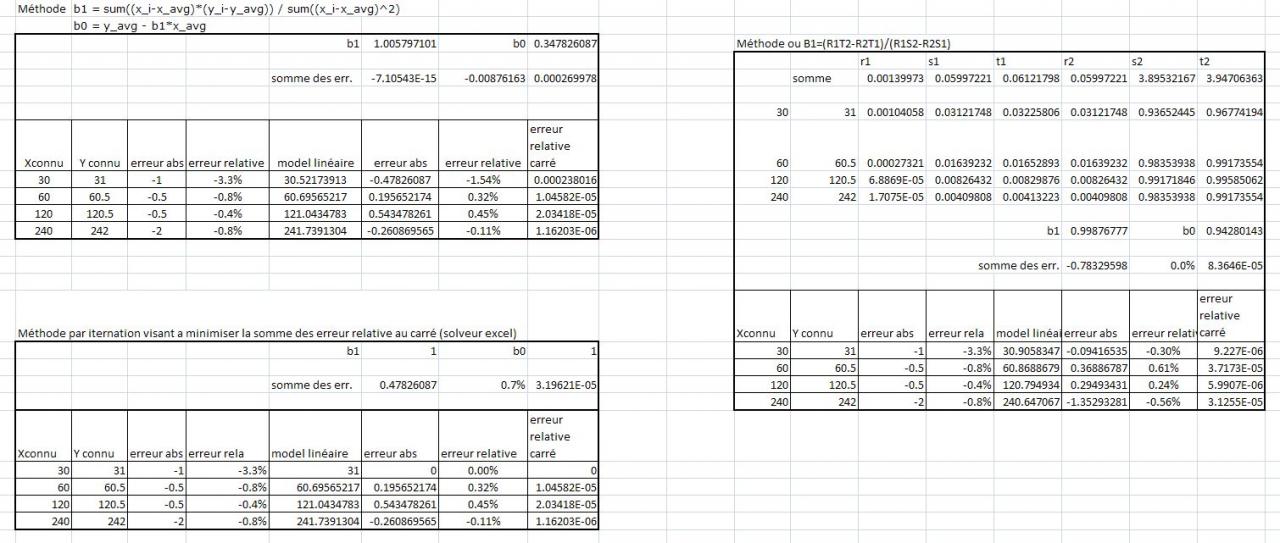

Jusqu’à présent j'utilise une régression linéaire par la méthode des moindres carrés, soit

y = b1*x + b0

b1 = sum((x_i-x_avg)*(y_i-y_avg)) / sum((x_i-x_avg)^2)

b0 = y_avg - b1*x_avg

cet méthode permet de minimiser les écarts absolus. or dans mon application ça cause problème car si j'ai un série de valeur comme suit

Xconnu Y connu erreur abs erreur relative model linéaire* erreur abs erreur relative

30 31 -1 -3,3% 30,31304348 -0,686956522 -2,2%

60 60 0 0,0% 60,5173913 0,517391304 0,9%

120 120,5 -0,5 -0,4% 120,926087 0,426086957 0,4%

240 242 -2 -0,8% 241,7434783 -0,256521739 -0,1%

* model linéaire selon la méthode des moindres carrés soit y = 1,006811594 x + 0,108695652.

mon problème est que ce model me donne un erreur relative après l'application du model linéaire de plus de 1% pour la le couple 30,31. car son poids dans la méthode des moindres carrés est 2 fois moins important que l'erreur du couple 240,242.

Comment effectuer une régression qui viserais à minimiser l'erreur relative?

Merci de votre aide

-----