Bonjour à tous!

Je vous expose mon problème du moment. J'ai à disposition un microncontroleur qui va recevoir en permanence des signaux sur son entrée analogique. Comme il s'agit d'un micro 12 bits, ce signal est représenté entre 0 et 4096 en sortie du CAN.

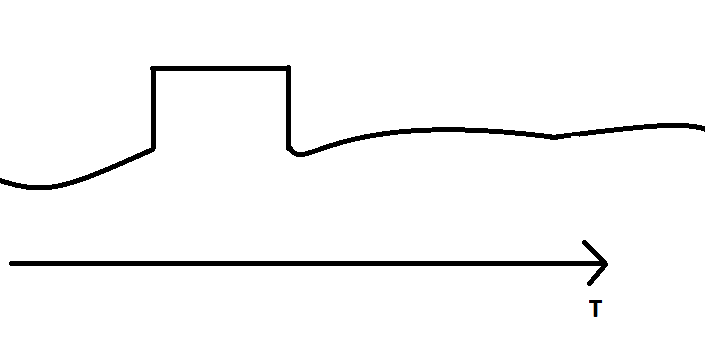

Mon but est d'identifier des créneaux. L'image suivante va être plus parlante:

je veux réussir à détecter cette forme quand elle survient. J'allume une led par exemple ou je déclenche un petit buzzer pour que l'on sache en temps réel si la forme est apparue. J'ai codé une méthode s'appuyant sur l'analyse des dérivées, mais je suis convaincu que l'on peut mieux faire. Elle donne des résultats intéressants, mais ne répond pas juste assez souvent à mon goût. Mon créneau n'est pas parfait dans la réalité, et n'est jamais exactement le même forme. C'est pourquoi je cherche d'autres méthodes. Je me suis tourné vers les algorithmes d'apprentissages (style RDN, ou autre). Un avantage est que je suis capable de fournir autant d'exemples d'apprentissages que je veux. Mais je ne vois pas trop comment m'y prendre. Des personnes ici ont codé des algo d'apprentissages sur microcontroleur?

Bonne après-midi à vous.

Peter

-----