I. Avant-propos : quelques notions.

L’entropie de Boltzmann définit l'entropie micro-canonique d'un système physique à l'équilibre macroscopique, mais laissée libre d'évoluer à l'échelle microscopique entre Oméga micro-états différents (appelé aussi nombre de complexions, ou encore nombre de configuration du système). L’unité est en Joule par Kelvin (J/K).

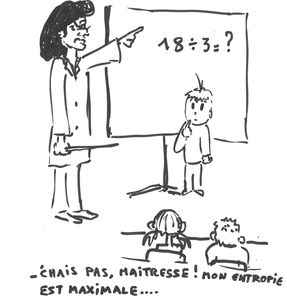

L'entropie de Shannon, due à Claude Shannon, est une fonction mathématique qui correspond à la quantité d'information contenue ou délivrée par une source d'information. Plus la source est redondante, moins elle contient d'information. L'entropie est ainsi maximale pour une source dont tous les symboles sont équiprobables. L'entropie de Shannon peut être vue comme mesurant la quantité d'incertitude liée à un événement aléatoire, ou plus précisément à sa distribution. Généralement, le logarithme sera en base 2 (base binaire). Un cas particulier est l'entropie de Von Neumann, utilisé en cryptographie quantique (voir les cours de Serge Laroche).

Maintenant que nous connaissons l’entropie de Boltzmann et l’entropie de Shannon, on peut fusionner les deux ce qui donne l’entropie de Boltzmann-Shannon. On peut considérer ainsi un système thermodynamique qui peut se trouver dans plusieurs états microscopiques "i", de probabilités respectives "p_i".

On sait que l’entropie est maximale lorsque les nombres de molécules dans chaque compartiment sont égaux. L’entropie est minimale si toutes les molécules sont dans un seul compartiment. Elle vaut alors 0 puisque le nombre d’états microscopiques vaut 1.

Du point de vue de la théorie de l’information, le système thermodynamique se comporte comme une source qui n’envoie aucun message. Ainsi, l’entropie mesure « l’information qui manque » au récepteur (ou l’incertitude de la totalité de l’information).

Si l’entropie est maximale (les nombres de molécules dans chaque compartiment sont égaux) l’information manquante est maximale. Si l’entropie est minimale (les nombres de molécules sont dans un même compartiment), alors l’information qui manque est nul.

II). La problématique.

La question est : Est-ce que l'entropie tend-elle toujours à son maximum, et cela, selon l'entropie de Shannon, ou selon l'entropie de Boltzmann, ou encore l'entropie de Boltzmann-Shannon ?

Remarque : La théorie holographique se base sur le principe d'entropie maximale : Le principe holographique dit qu'il y a au plus un degré de liberté (ou une constante de Boltzmann k, unité d'entropie maximale) pour chaque ensemble de quatre aires de Planck, ce qui peut être écrit comme une limite de Bekenstein (en) : S ≤ A/4, où S est l'entropie et A l'aire considérée.

Erik Verlinde l'explique aussi à propos de force entropique lié aux polymères : "Peut-être que l'exemple le plus connu est celui d'un polymère. Une seule molécule polymère peut être modélisée en joignant ensemble de nombreux monomères de longueur fixe, où chaque monomère peut librement tourner autour de points d'attache et s'orienter dans n'importe quelle direction. Chacune de ces configurations a la même énergie. Quand la molécule polymère est immergée dans un réservoir thermique, elle tend à se mettre dans un état enroulé de manière aléatoire car ces configurations sont favorisées d'un point de vue entropique. Il y a bien plus de configurations quand le système est court que lorsque le système est étiré. La tendance statistique à retourner vers un état d'entropie maximale se traduit alors en une force macroscopique, en l'occurrence la force élastique.". Une explication plus détaillé est présente sur

https://sciencetonnante.wordpress.co...ne-entropique/

Voilàmaintenant à vous d'y apporter votre lumière sur ce débat

-----