bonjour à tous.

j'ai une question qui sera certainement basique pour bon nombre d'entre vous mais pour moi c'est l'inconnu.

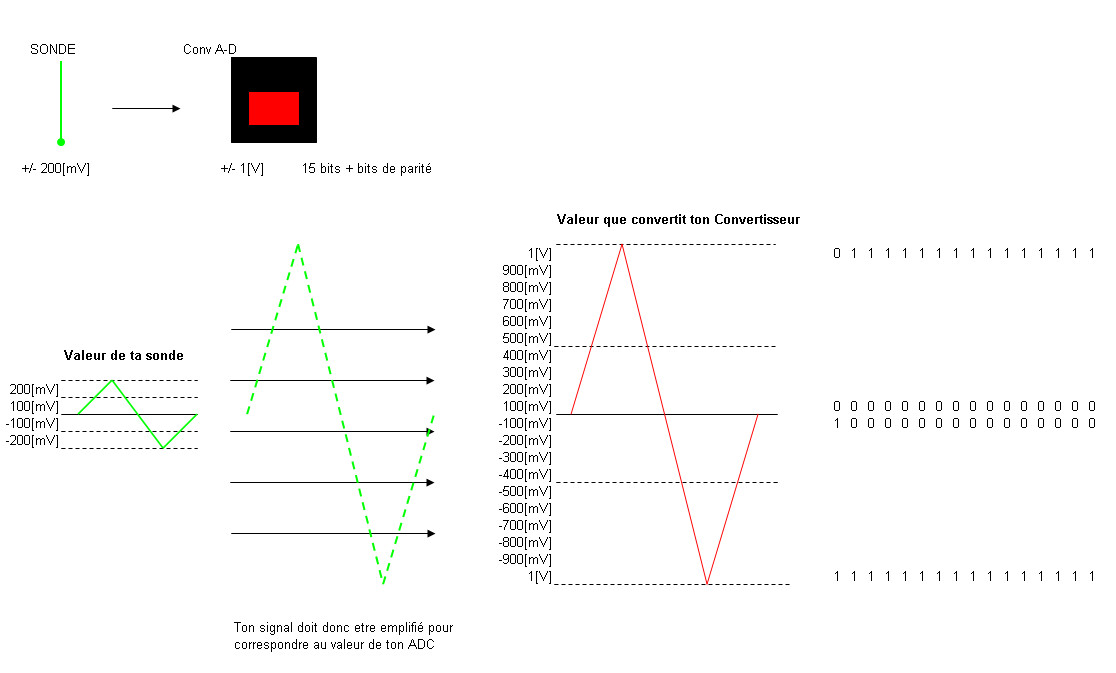

voilà je voudrais savoir comment on peut déterminer le nombre de bits nécessaire à une utilisation.

par exemple, j'ai un signal de 200mV, que je veux pouvoir lire à une precision de 0.01 mV.

si je suis en 16 bits, cela me fait 65536 possibilités (2^16).

donc je dois diviser mon signal max par cette valeur? 200/65536 = 0.003.

donc cela suffit.

mon calcul est-il le bon?

merci d'avance de m'aider.

-----

Putaing ! ... tu ne peux pas donner toutes les informations !

Putaing ! ... tu ne peux pas donner toutes les informations !