Bonjour,

j'étudie en ce moment le formalisme de Fisher dans le cadre de l'estimation de paramètres.

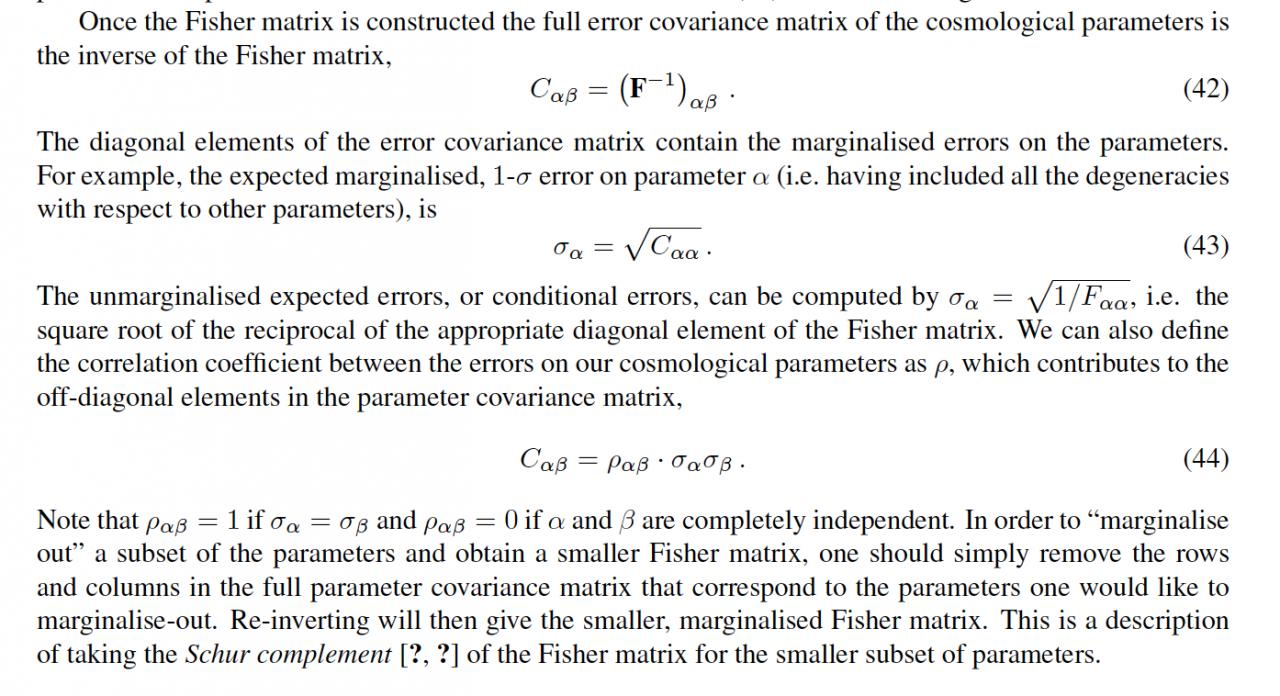

La matrice de Fisher est la matrice inverse de la matrice de covariance. Au départ, je construis une matrice "full" qui tient compte de tous les paramètres.

1) Projection : On peut alors faire ce que l'on appelle une projection, c'est-à-dire que l'on exprime cette matrice dans une autre base en utilisant la matrice jacobienne qui fait intervenir les dérivées des paramètres de départ par rapport aux nouveaux paramètres que l'on choisit : cette matrice est appelée "matrice projetée".

2) Marginalisation : Une fois que l'on a cette matrice projetée, on peut faire une autre opération qui est la "marginalisation d'un paramètre" : c'est-à-dire que l'on supprime dans la matrice projetée la ligne et la colonne correspondant à ce paramètre marginalisé.

Finalement, une fois que j'ai la matrice projetée, je peux l'inverser pour connaitre la matrice de covariance associée aux paramètres (les nouveaux).

QUESTION 1) Je voulais savoir si les opérations 1) et 2) sont commutatives, c'est-à-dire si les 2 séquences suivantes donnent le même résultat :

1ère séquence :

1.1) Partir de la matrice de Fisher "full"

1.2) Marginaliser par rapport à un paramètre (ou même plusieurs mais je m'intéresse d'abord à un seul), c'est-à-dire enlever la colonne et ligne correspondant au paramètre que l'on veut marginaliser.

1.3) Projeter avec le calcul faisant le produit :

1.4) Inverser la matrice projetée pour obtenir la matrice de covariance associée aux nouveaux paramètres

2ème séquence :

2.1) Partir de la matrice de Fisher "full"

2.2) Projeter avec les matrice jacobiennes

2.3) Marginaliser la matrice projetée = enlever la colonne et ligne correspondant au paramètre que l'on veut marginaliser.

2.4) Inverser la matrice projetée pour avoir la matrice de covariance

J'aimerais pouvoir le démontrer de manière analytique mais je sèche un peu, pour pas dire beaucoup. Si quelqu'un a des infos pour savoir si ces opérations sont commutatives ou pas, ça serait sympa de me donner quelques pistes ou infos.

QUESTION 2) Ce que j'ai du mal à saisir concernant ces 2 séquences ci-dessus, c'est que je ne marginalise pas le même paramètre (dans le 1er cas, sur un des paramètres de départ, dans le second sur un nouveau paramètre) : si c'est commutatif, je n'arrive pas à expliquer que ça donne dans les 2 cas la même matrice de covariance.

Si c'est pas très clair, n'hésitez pas à me demander des précisions (ça dépend desquelles car comme vous le voyez, je n'ai pas encore tout saisi).

Merci par avance.

-----