Bonjour à tous.

Dans mon cours de biophysique de médecine, on a vu une très brève application de la pression hydrostatique: le manomètre à liquide. Bien que je devrais apprendre ça bêtement comme les autres, je prends un moment pour essayer de comprendre.

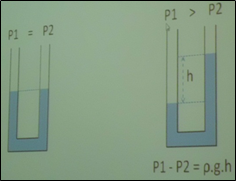

Comme vous le voyez, on me donne : Delta P = rho*g*h avec h la hauteur entre le haut liquide dans la partie gauche et le haut du même liquide dans la partie droite.

Imaginons notre manomètre avec du mercure, avec comme référence 1 atmosphère soit 760 mmHg avant de prendre la pression veineuse d'un patient. Il y a 760 mmHg de chaque côté, le liquide est au même niveau de chaque côté. On insère la partie de gauche du manomètre dans la veine du patient (c'est un exemple fictif bien sur).

Si le patient à une pression veineuse de 860 mmHg (soit 760 +100) par exemple, pourquoi le liquide n'est-il pas poussé de 100 mm de chaque côté ? C'est à dire 100 mm plus bas à gauche et 100 mm plus haut à droite ? Ce qui donnerait une valeur fausse de 200 mmHg de différence de pression avec la mesure de h comme il y a dans mon cours. J'ai tord et je le sais, mais j'aimerais comprendre pourquoi ça ne pousse que de 50 mm à gauche à droite (donc le liquide ne s'est déplacé que de 50 mm) et non 100 ?

Est-ce que ça a un rapport avec le fait que le liquide du manomètre doive "pousser" contre l'atmosphère, ou le poids du liquide ?

-----