- Forum

- Futura-Sciences : les forums de la science

- INFOS

- Actualités

- Petite réflexion sur l'IA et l'usage des outils comme ChatGPT

Petite réflexion sur l'IA et l'usage des outils comme ChatGPT

- 29/03/2023, 09h36 #61Archi3

- Date d'inscription

- novembre 2011

- Messages

- 6 706

Re : Petite réflexion sur l'IA et l'usage des outils comme ChatGPT

------

- 29/03/2023, 10h05 #62agitateur

- Date d'inscription

- mars 2010

- Âge

- 49

- Messages

- 10 548

Re : Petite réflexion sur l'IA et l'usage des outils comme ChatGPT

- 29/03/2023, 10h23 #63pm42

- Date d'inscription

- juillet 2015

- Messages

- 15 279

Re : Petite réflexion sur l'IA et l'usage des outils comme ChatGPT

Oui et ce genre d'argument ne tient pas la route pour plein de raisons :

- personne ne prétend que les IA peuvent remplacer les avocats actuellement

- GPT-4 réussit quand même à passer un examen d'entrée en fac de droit. C'est l'état de l'art et c'est déjà pas mal

- on ne sait pas d'où sort ce chiffre de 20% qui relève de la théorie perso/l'affirmation gratuite.

- OpenAI précise bien qu'il ne faut pas utiliser ces outils pour un usage critique. Donc si je veux faire un plan de présentation sur un sujet, il va me sortir quelque chose de super qui me fait gagner du temps. Je ne vais pas lui demander un diagnostic médical par contre (et il le signale)

- par contre, les IAs sont déjà utilisées pour certaines tâches et faire gagner du temps dans certains cabinets d'avocats

Un autre biais qui rejoint la mythification de l'intelligence dont je parlais plus haut et qui correspond à ta blague sur les avocats qui se trompent à plus de 20%, c'est qu'effectivement le taux d'erreur des humains dans leur métier est relativement élevé.

On corrige ça par le fait que la plupart sont facile à rattraper, par la vérification croisée, les contrôles qualités et autres mécanismes...

Mais il y a eu des études intéressantes qui montraient que justement ce taux était non négligeable et constant le long d'une hiérarchie : le PDG fait autant d'erreurs que le balayeur mais les difficultés, responsabilités et conséquences ne sont pas les mêmes.

- 29/03/2023, 11h04 #64yves95210

- Date d'inscription

- septembre 2013

- Messages

- 6 113

Re : Petite réflexion sur l'IA et l'usage des outils comme ChatGPT

Salut,

Je réagis à ce message :

Une question naïve : le traitement du langage par GPT, qui n'a apparemment pas grand-chose à voir avec le traitement (spécifique à chaque langue) du langage écrit par les humains, ne se rapproche t-il pas plutôt de la manière dont les humains "traitent" le langage parlé (avant l'apprentissage de l'écriture ou avant son invention dans les cultures qui n'ont / n'avaient pas de langage écrit) ?je n'appelle pas un truc qui n'est pas capable de sortir le nombre de voyelles dans son nom "un outil de TRAITEMENT du langage"

Cela peut sembler paradoxal puisque tout l'apprentissage de GPT est basé sur l'absorption de textes écrits, mais est au fond assez logique puisque (si j'ai bien compris, et en schématisant à l'extrême) son fonctionnement est basé sur la probabilité de rencontrer tel ou tel mot (ou suite de mots) à proximité de tel ou tel autre mot (ou suite de mots) dans un texte.

Comme (là aussi, je simplifie sans-doute abusivement) lorsqu'un enfant finit par comprendre intuitivement la signification d'un mot plus ou moins abstrait (ne représentant pas un objet qu'on peut lui montrer, ou une propriété de cet objet comparée avec celle d'un autre) à force de l'entendre associé avec d'autres dans des phrases et des contextes particuliers, et n'a pas besoin pour l'identifier de se le représenter sous forme d'une suite de voyelles et de consonnes (ou plus généralement, de phonèmes). Ou qui, ayant déjà rencontré un mot mais toujours associé à (suivi ou précédé par) un autre, ne comprendrait que la signification de ce groupe de mots et serait incapable de les dissocier. Ce qui ne l'empêche pas de construire des phrases cohérentes, utilisant ces mots à bon escient.

Avec en plus pour GPT la difficulté venant du fait qu'aucun mot ne représente pour lui quelque-chose de concret, qu'il pourrait percevoir par ses sens (il n'en a pas) et qu'on pourrait lui montrer. Ce qui fait que lorsqu'on lui pose une question "piège", ne demandant apparemment pas de faire appel à des connaissances qu'il peut avoir par ailleurs, par exemple sur l'intérêt culinaire comparé d'un œuf de vache et d'un œuf de poule, il est capable de discourir sérieusement et de manière parfaitement absurde sur le sujet. Comme un petit enfant qui n'a pas appris qu'une vache ne pond pas d'œufs, mais qui a déjà vu et mangé des œufs de poule, répondrait naïvement qu'un œuf de vache est ovale (ou rond s'il n'a pas appris le sens du mot ovale) si on lui posait la question.

Contrairement à l'enfant, GPT est censé savoir qu'une vache est un mammifère et qu'en général (il y a des exceptions) un mammifère ne pond pas d'œufs. Mais ces connaissances font partie d'un autre domaine (plutôt scientifique, faisant appel à la classification des espèces, et dans lequel aucun texte ne dit explicitement "une vache ne pond pas d'œufs") et sont associées à un autre contexte que celui dans lequel la question lui est posée, ce qui fait qu'il répond à cette question sans faire le lien avec elles.

- 29/03/2023, 11h19 #65pm42

- Date d'inscription

- juillet 2015

- Messages

- 15 279

Re : Petite réflexion sur l'IA et l'usage des outils comme ChatGPT

Il faut en effet faire attention avec les analogies mais celle là n'est pas fausse.Une question naïve : le traitement du langage par GPT, qui n'a apparemment pas grand-chose à voir avec le traitement (spécifique à chaque langue) du langage écrit par les humains, ne se rapproche t-il pas plutôt de la manière dont les humains "traitent" le langage parlé (avant l'apprentissage de l'écriture ou avant son invention dans les cultures qui n'ont / n'avaient pas de langage écrit) ?

Oui, c'est très bien expliqué dans le lien du NY Times que j'ai donné plus haut.

A titre indicatif, nous faisons cela tout le temps : nous interprétons ce que nous lisons/entendons via des probabilités qui dépendent du contexte.

Un exemple était un oral d'HEC : "parlez nous de l'amour". Le candidat parle du sentiment, c'est logique vu que c'est l'emploi le plus fréquent du mot.

Et l'examinateur l'interrompt au bout d'un certain temps en lui disant "non, je parlais du fleuve en Chine".

Tout ça pour dire qu'on utilise également massivement les probabilités dans le cerveau humain.

Oui, notre apprentissage n'est pas algorithmique du tout. C'est aussi pour ça que les tentatives de modéliser le langage formellement ont été des échecs notamment les travaux de Chomsky. Mais ça a bien servi pour les langages informatiques.Comme (là aussi, je simplifie sans-doute abusivement) lorsqu'un enfant finit par comprendre intuitivement la signification d'un mot plus ou moins abstrait (ne représentant pas un objet qu'on peut lui montrer, ou une propriété de cet objet comparée avec celle d'un autre) à force de l'entendre associé avec d'autres dans des phrases et des contextes particuliers, et n'a pas besoin pour l'identifier de se le représenter sous forme d'une suite de voyelles et de consonnes (ou plus généralement, de phonèmes). Ou qui, ayant déjà rencontré un mot mais toujours associé à (suivi ou précédé par) un autre, ne comprendrait que la signification de ce groupe de mots et serait incapable de les dissocier. Ce qui ne l'empêche pas de construire des phrases cohérentes, utilisant ces mots à bon escient.

On peut également remarquer que pas mal d'animaux ont des langages plus simples que les humains certes mais qu'ils seraient bien incapables de "compter les voyelles".

On peut dire cela aussi pour les langues non écrites, pour les idéogrammes, etc.

Confondre "traiter le langage c'est à dire le comprendre et le parler" et "être capable de répondre à des questions algorithmiques sur sa représentation écrite" mène effectivement à des contresens.

C'est à la fois une faiblesse mais aussi une force : cela lui permet d'avoir des discussions "créatives" comme nous le faisons quand on fait de l'humour par exemple.Avec en plus pour GPT la difficulté venant du fait qu'aucun mot ne représente pour lui quelque-chose de concret, qu'il pourrait percevoir par ses sens (il n'en a pas) et qu'on pourrait lui montrer. Ce qui fait que lorsqu'on lui pose une question "piège", ne demandant apparemment pas de faire appel à des connaissances qu'il peut avoir par ailleurs, par exemple sur l'intérêt culinaire comparé d'un œuf de vache et d'un œuf de poule, il est capable de discourir sérieusement et de manière parfaitement absurde sur le sujet.

Encore une fois, le but n'est pas d'avoir un "ordinateur désincarné qui répond froidement et factuellement" comme dans la SF mais bien quelque chose qui saisit l'énorme variété des langages.

Ce qui est intéressant (et je me répète), c'est de voir apparaitre malgré cela des capacités émergentes comme le codage informatique ou la résolution de problèmes de maths.

- 29/03/2023, 11h29 #66GBo

- Date d'inscription

- novembre 2005

- Localisation

- RP Ouest (78)

- Messages

- 4 523

Re : Petite réflexion sur l'IA et l'usage des outils comme ChatGPT

Salut Yves, justement non, GPT n'est pas censé savoir qu'une vache est un mammifère, si tu lui demandes il va te dire que c'est un mammifère car il a rencontré x fois cette corrélation dans le corpus géant de textes, mais il ne le sait pas vraiment, il n'a aucune notion de biologie contrairement à l'enfant lorsqu'il aura appris ce que c'est. Et quand le petit d'Homme aura assisté à la naissance d'un veau, il ne fera plus JAMAIS la confusion avec la ponte d'une pouleSalut,

[...]

Contrairement à l'enfant, GPT est censé savoir qu'une vache est un mammifère et qu'en général (il y a des exceptions) un mammifère ne pond pas d'œufs. Mais ces connaissances font partie d'un autre domaine (plutôt scientifique, faisant appel à la classification des espèces, et dans lequel aucun texte ne dit explicitement "une vache ne pond pas d'œufs") et sont associées à un autre contexte que celui dans lequel la question lui est posée, ce qui fait qu'il répond à cette question sans faire le lien avec elles.

C'est tout l'objet du travail de LeCun (et d'autres) sur le "world model" et autre "common sense" qui manquent entre autre à cette approche par LLM (exclusivement textuels, mais c'est de la recherche fondamentale, pas de produit en vue avant longtemps !

A Path Towards Autonomous Machine Intelligence

https://openreview.net/pdf?id=BZ5a1r-kVsfDernière modification par GBo ; 29/03/2023 à 11h34.

- 29/03/2023, 11h36 #67jiherve

- Date d'inscription

- juin 2006

- Localisation

- gironde

- Âge

- 73

- Messages

- 27 978

Re : Petite réflexion sur l'IA et l'usage des outils comme ChatGPT

bonjour

non en fait chatGPT ne sait rien* car pour savoir il faut être, il ne fait qu'associer des chaines de caractères de façon plausible, dans le passé il y eu les GPA là c'est beaucoup mieux pour ceux dont l'activité principale c'est la tchatche.

*voir la vidéo avec les requins classés en mammifères.

JRl'électronique c'est pas du vaudou!

- 29/03/2023, 12h02 #68GBo

- Date d'inscription

- novembre 2005

- Localisation

- RP Ouest (78)

- Messages

- 4 523

Re : Petite réflexion sur l'IA et l'usage des outils comme ChatGPT

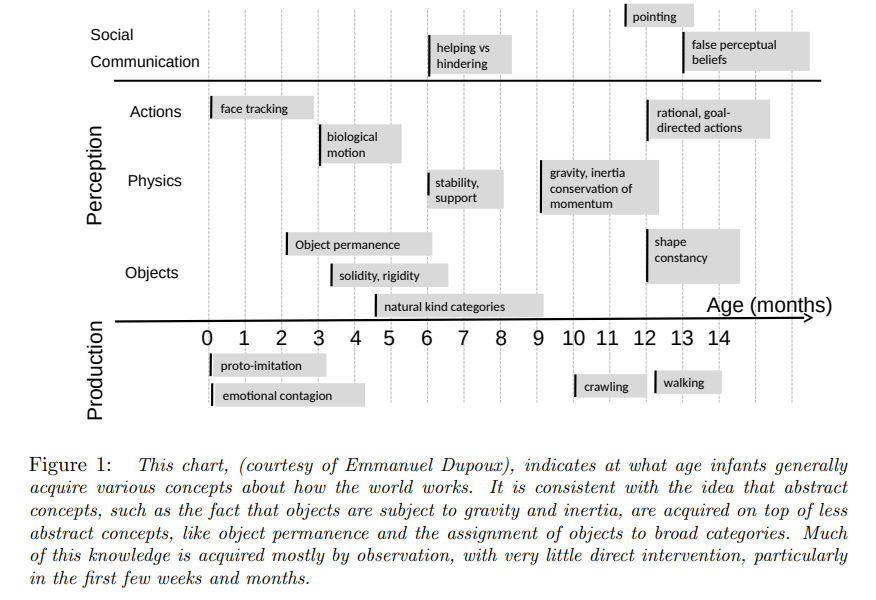

En extrait de ce papier, regardez tout ce qu'a appris un bébé de 14 mois sans avoir lu aucun texte, et pour cause:C'est tout l'objet du travail de LeCun (et d'autres) sur le "world model" et autre "common sense" qui manquent entre autre à cette approche par LLM (exclusivement textuels, mais c'est de la recherche fondamentale, pas de produit en vue avant longtemps !

A Path Towards Autonomous Machine Intelligence

https://openreview.net/pdf?id=BZ5a1r-kVsf

Et rien de tout ça ne sera écrit ou lu ensuite, car c'est du "bon sens". Le fait de dire que l'ensemble des textes du web comporte toute la connaissance de l'humanité comme on peut l'entendre de la part de fanboys d'OpenAI est largement optimiste, pour rester gentil.Dernière modification par GBo ; 29/03/2023 à 12h07.

- 29/03/2023, 12h07 #69mh34

Responsable des forums

- Date d'inscription

- mars 2008

- Messages

- 16 345

Re : Petite réflexion sur l'IA et l'usage des outils comme ChatGPT

Effectivement, c'est faire fi de la connaissance acquise par l'intermédiaire des sens et de la proprioception. Tout ne peut pas être transcrit en écriture ni même transmis par le langage, c'est vrai.

- 29/03/2023, 12h10 #70polo974

- Date d'inscription

- février 2007

- Messages

- 9 726

Re : Petite réflexion sur l'IA et l'usage des outils comme ChatGPT

Qui a dit ça ici ? ? ?

Jusqu'ici tout va bien...

- 29/03/2023, 12h14 #71pm42

- Date d'inscription

- juillet 2015

- Messages

- 15 279

Re : Petite réflexion sur l'IA et l'usage des outils comme ChatGPT

- 29/03/2023, 12h19 #72yves95210

- Date d'inscription

- septembre 2013

- Messages

- 6 113

Re : Petite réflexion sur l'IA et l'usage des outils comme ChatGPT

Pas d'accord. Quelle que soit la façon dont GPT a acquis ce "savoir", ça reste un savoir.Salut Yves, justement non, GPT n'est pas censé savoir qu'une vache est un mammifère, si tu lui demandes il va te dire que c'est un mammifère car il a rencontré x fois cette corrélation dans le corpus géant de textes, mais il ne le sait pas vraiment, il n'a aucune notion de biologie contrairement à l'enfant lorsqu'il aura appris ce que c'est.

L'enfant n'a pas besoin d'avoir des notions (abstraites) de biologie pour "savoir" que la vache fait partie d'un ensemble d'animaux qui ont en général quatre pattes (ou deux et deux bras) et qui ne pondent en général pas d'œufs. Et quand à cette affirmation :

... encore faut-il qu'il ait compris l'analogie entre la naissance d'un veau et la ponte d'un œuf (et le fait que l'œuf devient un poussin). Sinon, rien ne l'empêche d'imaginer que, en plus de faire des veaux, la vache est capable de pondre des œufs...Et quand le petit d'Homme aura assisté à la naissance d'un veau, il ne fera plus JAMAIS la confusion avec la ponte d'une poule

Mais justement, c'est bien parce que GPT ne peut pas faire ce genre d'expérience que son "savoir" reste abstrait et que, faute d'être incité à corréler des connaissances "livresques" acquises dans un certain contexte (par exemple la biologie) avec une question posée dans un autre contexte (par exemple la cuisine ou les aliments consommés par les humains), il n'est pas capable de comprendre l'absurdité d'une question portant sur l'intérêt culinaire de l'œuf de vache.

Cela ne veut pas dire qu'il ne dispose pas de ces connaissances (c'est quoi d'autre, le "savoir" ?), seulement que la façon dont il les utilise n'est pas (encore ?) optimisée.

Mais c'est aussi le cas des humains qui, certes, sont plus que GPT capables de faire appel intuitivement (instinctivement quand c'est quelque-chose que leurs sens leur ont permis d'expérimenter) à tel ou tel aspect de leur savoir (par exemple "la gravitation" qui fait que s'ils tombent d'un pont ils vont se faire mal), mais à qui cette intuition peut faire défaut lorsqu'ils répondent à des questions piège (par leur contexte). Je ne suis pas sûr qu'au moins une partie des humains qui (même sans avoir étudié la biologie) connaissent l'existence de l'ornithorynque ne prendraient pas à la rigolade une question du genre "est qu'on c'est bon, les œufs de mammifères ?", dans le cadre d'une discussion autour des pratiques culinaires...

Donc non, le fait que GPT peut se tromper, voire raconter des absurdités, (et souvent; et d'autant plus qu'on exploite volontairement ses failles) ne démontre en rien une absence de "savoir" au sens humain du terme (qui finalement n'est guère mieux défini que le mot "intelligence"). Tous les "savoirs" humains ne sont pas de même nature, ni acquis de la même manière. Certains sont liés aux sens (qui font évidemment défaut à GPT) mais d'autres non.

- 29/03/2023, 12h25 #73yves95210

- Date d'inscription

- septembre 2013

- Messages

- 6 113

Re : Petite réflexion sur l'IA et l'usage des outils comme ChatGPT

et un chaton de 2 ou 3 mois aussi, non ?En extrait de ce papier, regardez tout ce qu'a appris un bébé de 14 mois sans avoir lu aucun texte, et pour cause:

Pièce jointe 477172

- 29/03/2023, 12h30 #74oualos

- Date d'inscription

- mars 2023

- Messages

- 1 228

Re : Petite réflexion sur l'IA et l'usage des outils comme ChatGPT

vous raisonnez comme si l'intelligence et le savoir étaient des démarches innées et quasi-naturelles chez l'homme.

Au risque de me faire réprimander, je citerais deux choses, l'une drôle l'autre nettement moins. La première est une citation de Woody allen.

1° Qu'est-ce que l'intelligence artificielle ? C'est le contraire de la bêtise naturelle.

2° La bêtise et l'inculture s'apprennent aussi.

#### supprimé : point GodwinDernière modification par JPL ; 29/03/2023 à 14h27.

- 29/03/2023, 12h34 #75pm42

- Date d'inscription

- juillet 2015

- Messages

- 15 279

Re : Petite réflexion sur l'IA et l'usage des outils comme ChatGPT

- 29/03/2023, 12h36 #76GBo

- Date d'inscription

- novembre 2005

- Localisation

- RP Ouest (78)

- Messages

- 4 523

Re : Petite réflexion sur l'IA et l'usage des outils comme ChatGPT

Je ne sais pas si c'est une question sérieuse, mais au cas où : non pas vraiment. Par contre le chat adulte a certainement un meilleur "world model" que le chat GPT qui n'en a aucun, à moins qu'on lui découvre un jour une propriété émergente digne de ce qui pourrait être appelé un word model.

Dernière modification par GBo ; 29/03/2023 à 12h40.

- 29/03/2023, 13h03 #77mh34

Responsable des forums

- Date d'inscription

- mars 2008

- Messages

- 16 345

Re : Petite réflexion sur l'IA et l'usage des outils comme ChatGPT

Question ; on est d'accord que chat GPT est un outil, n'est-ce pas?

Donc que faut-il en connaitre pour l'utiliser correctement?

Si je fais un parallèle avec l'outil que j'utilise tous les jours : je n'ai pas besoin de savoir comment il a été fabriqué, par contre j'ai besoin d'en connaitre un minimum sur le principe physique utilisé.

Mais j'ai aussi besoin de connaitre d'autres domaines en rapport avec le résultat que j'obtiens ( parce que je ne peux analyser ce résultat qu'au travers de ces autres connaissances, indépendantes du principe physique en question). Connaissances qui sont augmentées par l'expérience, mais aussi par le partage avec d'autres utilisateurs.

Faut-il un arrière-plan équivalent pour chat GPT?

- 29/03/2023, 13h10 #78yves95210

- Date d'inscription

- septembre 2013

- Messages

- 6 113

Re : Petite réflexion sur l'IA et l'usage des outils comme ChatGPT

C'était un peu de la provocation. Mais pour répondre "non", il faudrait que tu précises lesquels de ces "savoirs" le chat (pas GPT) n'est pas capable d'acquérir dans les premiers mois de son existence (en excluant ceux qui sont éventuellement liés à la communication par le langage).

Là, tu enfonces clairement une porte ouverte...Par contre le chat adulte a certainement un meilleur "world model" que le chat GPT qui n'en a aucun, à moins qu'on lui découvre un jour une propriété émergente digne de ce qui pourrait être appelé un word model.

Mais GPT n'a pas besoin d'exister dans le "world" (le monde dans lequel nous vivons) représenté par des "world models" dans le cerveau des animaux (et des humains). Et le "world model" qui pourrait émerger chez une IA (pas GPT, qui n'est pas équipé pour) n'aurait probablement rien à voir avec le nôtre.

- 29/03/2023, 13h11 #79mh34

Responsable des forums

- Date d'inscription

- mars 2008

- Messages

- 16 345

Re : Petite réflexion sur l'IA et l'usage des outils comme ChatGPT

- 29/03/2023, 13h25 #80pm42

- Date d'inscription

- juillet 2015

- Messages

- 15 279

Re : Petite réflexion sur l'IA et l'usage des outils comme ChatGPT

Oui.

Ses possibilités et ses limites. Par exemple, on sait qu'il est plutôt bon pour faire de la synthèse d'informations ou pour générer des plans de documents, etc.

Mais qu'il n'est pas un moteur de recherche, qu'il peut se "tromper" si on lui demande un raisonnement.

En fait, il est tellement généraliste que tout dépend de l'usage qu'on va en faire. C'est un peu comme Internet ou un smartphone : on a tous un usage personnalisé.

Tout dépend de l'usage. Ce que tu dis laisse à penser que tu parles d'un outil professionnel spécialisé et ce n'est pas ce pourquoi ChatGPT est fait.Si je fais un parallèle avec l'outil que j'utilise tous les jours : je n'ai pas besoin de savoir comment il a été fabriqué, par contre j'ai besoin d'en connaitre un minimum sur le principe physique utilisé.

Mais j'ai aussi besoin de connaitre d'autres domaines en rapport avec le résultat que j'obtiens ( parce que je ne peux analyser ce résultat qu'au travers de ces autres connaissances, indépendantes du principe physique en question). Connaissances qui sont augmentées par l'expérience, mais aussi par le partage avec d'autres utilisateurs.

Faut-il un arrière-plan équivalent pour chat GPT?

Mais si tu dois faire une présentation sur un sujet donné, tu peux très bien lui demander un plan et le prendre et l'adapter et gagner du temps : pas besoin de background spécifique.

Voici un petit exemple :

considères tu es un cancérologue et fais moi le plan d'une présentation sur le traitement du cancer du sein.

En tant que modèle de langage, je ne suis pas un cancérologue qualifié et je ne peux pas donner de conseils médicaux spécifiques ou de plans de traitement personnalisés. Cependant, je peux vous fournir un plan général pour une présentation sur le traitement du cancer du sein.

Plan de présentation sur le traitement du cancer du sein :

I. Introduction

A. Statistiques sur le cancer du sein

B. Types de cancer du sein

II. Diagnostic et évaluation

A. Examen physique

B. Imagerie diagnostique

C. Biopsie

III. Stades et classification

A. Stade 0

B. Stade I

C. Stade II

D. Stade III

E. Stade IV

IV. Options de traitement

A. Chirurgie

B. Chimiothérapie

C. Radiothérapie

D. Thérapies ciblées

E. Hormonothérapie

V. Gestion des effets secondaires

A. Effets secondaires de la chimiothérapie

B. Effets secondaires de la radiothérapie

C. Gestion de la douleur

VI. Soins de soutien

A. Soutien émotionnel

B. Réadaptation physique

C. Soins palliatifs

VII. Prévention et dépistage

A. Autopalpation

B. Mammographie

C. Prévention du cancer du sein

VIII. Conclusion

A. Récapitulation des options de traitement

B. Importance de la détection précoce

C. Espoir pour l'avenir

Il est important de noter que ce plan est général et qu'il est essentiel de travailler avec un professionnel de la santé qualifié pour développer un plan de traitement personnalisé.

100 fois par fil sur tous les fils ? Je sais bien que la pédagogie est l'art de la répétition mais la plupart des gens ici comprennent avant la 100ème fois.

- 29/03/2023, 13h27 #81pm42

- Date d'inscription

- juillet 2015

- Messages

- 15 279

Re : Petite réflexion sur l'IA et l'usage des outils comme ChatGPT

Un autre exemple :

maintenant, tu es un radiologue et fais l'historique de l'évolution de l'IRM

En tant que modèle de langage, je suis capable de vous donner un aperçu de l'historique de l'évolution de l'IRM en tant que radiologue.

L'IRM (imagerie par résonance magnétique) est une technique d'imagerie médicale qui utilise des champs magnétiques et des ondes radio pour créer des images détaillées de l'intérieur du corps.

L'histoire de l'IRM remonte aux années 1940, lorsque le physicien américain Isidor Rabi a découvert la résonance magnétique nucléaire (RMN), qui permet de mesurer les propriétés magnétiques des atomes. Dans les années 1950, le physicien britannique Peter Mansfield a développé la technologie de gradient de champ magnétique, qui a permis d'obtenir des images en deux dimensions.

Dans les années 1970, Raymond Damadian, un médecin américain, a été le premier à utiliser la RMN pour l'imagerie médicale en développant le premier scanner corporel à résonance magnétique. Cette technologie était rudimentaire, coûteuse et nécessitait de nombreuses heures pour produire des images.

Cependant, dans les années 1980, la technologie de l'IRM a considérablement évolué avec l'introduction de machines plus puissantes et plus rapides. Les machines d'IRM ont été miniaturisées pour permettre une utilisation dans les hôpitaux et les cliniques, et les temps d'examen ont été considérablement réduits.

Au fil du temps, les progrès de la technologie ont permis l'amélioration de la qualité des images et l'introduction de nouvelles séquences d'imagerie, telles que l'imagerie par diffusion, l'imagerie fonctionnelle et l'imagerie spectroscopique.

Aujourd'hui, l'IRM est devenue un outil essentiel pour le diagnostic et le traitement de nombreuses maladies, notamment les cancers, les maladies cardiaques et neurologiques. Les machines d'IRM modernes sont plus rapides, plus précises et plus polyvalentes que jamais, permettant aux radiologues d'obtenir des images détaillées de l'intérieur du corps sans exposition aux radiations.

- 29/03/2023, 13h28 #82pm42

- Date d'inscription

- juillet 2015

- Messages

- 15 279

Re : Petite réflexion sur l'IA et l'usage des outils comme ChatGPT

J'ai trouvé que c'était un peu court donc j'ai demandé des détails :

Peux tu détailler les évolutions de l'IRM depuis les années 1980 ?

Bien sûr, je peux vous fournir une liste des principales évolutions de l'IRM depuis les années 1980 :

Augmentation de la puissance des aimants : Les machines d'IRM ont commencé à utiliser des aimants plus puissants, ce qui a permis d'obtenir des images plus détaillées et de réduire les temps d'examen.

Introduction de l'imagerie en 3D : Les machines d'IRM ont commencé à produire des images en trois dimensions, ce qui a permis une meilleure visualisation et une meilleure compréhension des structures anatomiques.

Amélioration de la qualité des images : Les technologies d'imagerie telles que la réduction du flou de mouvement, la suppression de l'effet de volume partiel et l'amélioration de la résolution spatiale ont permis d'obtenir des images plus nettes et plus précises.

Introduction de nouvelles séquences d'imagerie : L'IRM a connu l'introduction de nouvelles séquences d'imagerie, telles que l'imagerie par diffusion, l'imagerie fonctionnelle et l'imagerie spectroscopique, qui ont permis aux radiologues de diagnostiquer des maladies avec plus de précision.

Réduction des temps d'examen : Les machines d'IRM ont été améliorées pour réduire les temps d'examen et rendre l'IRM plus rapide et plus accessible pour les patients.

Amélioration de la convivialité : Les machines d'IRM ont été miniaturisées, ce qui a permis leur installation dans les hôpitaux et les cliniques, et les temps d'examen ont été réduits pour rendre l'IRM plus confortable pour les patients.

Développement de l'IRM à haut champ : L'IRM à haut champ utilise des aimants encore plus puissants que les machines d'IRM traditionnelles pour obtenir des images encore plus détaillées.

Amélioration de la sécurité : Les machines d'IRM ont été améliorées pour être plus sûres pour les patients, avec des protocoles de sécurité pour éviter les risques de brûlures, de chocs électriques et d'autres complications.

- 29/03/2023, 13h30 #83pm42

- Date d'inscription

- juillet 2015

- Messages

- 15 279

Re : Petite réflexion sur l'IA et l'usage des outils comme ChatGPT

Donc bien sur, on est très loin de remplacer un expert et c'est clairement précisé par les concepteurs eux-mêmes.

Mais cela peut permettre de gagner beaucoup de temps dans beaucoup de tâches.

P.S : les réponses précédentes sont du pur ChatGPT. Je n'ai pas essayé avec GPT-4 qui est plus précis et fait moins d'erreurs.

- 29/03/2023, 13h37 #84ArchoZaure

- Date d'inscription

- novembre 2022

- Âge

- 49

- Messages

- 1 926

Re : Petite réflexion sur l'IA et l'usage des outils comme ChatGPT

Je pense qu'on ne peut pas dire ça comme ça de manière générale.

En fait il y a des structure neuronales qui se mettent en place et qui ressemblent fonctionnellement à celles employées dans le IA.

Comme par exemple pour certaines parties du système visuel primaire.

On peut alors dire qu'on possède là des structures faisant des traitements sur des signaux (ou données pour les machines) en entrée qu'on peut qualifier d'intelligent.

Mais ce n'est pas le cas pour toutes les faculté humaines.

En particulier tout ce qui touche au langage à un niveau supérieur ne fait pas appel à ces structures qu'on retrouve actuellement dans les IA.

Par contre, l'apprentissage du langage, à un niveau inférieur donc, son emploi correct, est lui très certainement "non algorithmique", comme beaucoup d'autres fonctions cognitives automatisées.

Ce qui fournit là aussi de l'intelligence.

Ça va même assez loin et ça rejoint la réflexion que vous aviez dans votre premier message : Est-ce que le langage par lui-même, sa structuration faisant appel au temps, l'espace, etc et le fait d'avoir des mots faisant appel à des catégories, ne renferme pas lui-même, indépendamment même de son usage, de l'intelligence ?

Pour le dire autrement et sommairement : Un idiot qui apprendrait à parler, sans même avoir accès au monde, ne pourrait-il pas bénéficier de cette "intelligence formalisée, cristallisée si je puis dire dans un formalisme" pour pouvoir dire des choses qu'on supposerait intelligentes, qui paraitraient "nouvelles" mais qui ne se sont pas en réalité (car le langage est un système à possibilités immenses mais fini) ?

Et c'est là où "l'intelligent" (c'est nous ) va plus loin, car il ne s'appuie pas uniquement sur ce qu'apporte l'emploi du langage ou ses automatismes, il réfléchit plusieurs fois et tourne 3 fois sa langue dans sa tête avant de sortir une grosse connerie (ce que ne font pas les l'IA genre GPT).

) va plus loin, car il ne s'appuie pas uniquement sur ce qu'apporte l'emploi du langage ou ses automatismes, il réfléchit plusieurs fois et tourne 3 fois sa langue dans sa tête avant de sortir une grosse connerie (ce que ne font pas les l'IA genre GPT).

On a aussi ce même défaut (puisqu'on fait appel aux automatismes et au langage) mais on va un cran plus loin.

Pour donner un exemple : Si vous stressez un interlocuteur en lui posant des questions et lui demandez de répondre le plus rapidement possible, en lui intercalant sans qu'il s'en doute des questions auxquelles il va répondre par la couleur blanche (quelle est la couleur de cette feuille de papier etc) vous pouvez à la fin lui demander : Que boit une vache ?

Et presque invariablement, sauf pour les tricheurs qui ne jouent pas le jeu et qui prennent un petit peu plus de temps pour répondre, la réponse est.... du lait.

Si on ne fait appel qu'aux automatismes, on va parfois faire des grosses erreurs.

J'ai essayé avec GPT3. Lui ne fait pas cette erreur et c'est normal puisque le savoir "une vache boit de l'eau" est bien plus présente dans sa base de travail.

Mais en réfléchissant un peu plus... on sait qu'un veau (faisant partie de la catégorie "vache") boit AUSSI du lait, donc c'est plus compliqué que ça en a l'air (ne se prête pas au traitement par des automatismes).Dernière modification par ArchoZaure ; 29/03/2023 à 13h38.

- 29/03/2023, 14h43 #85JPL

Responsable des forums

- Date d'inscription

- septembre 2003

- Messages

- 64 311

Re : Petite réflexion sur l'IA et l'usage des outils comme ChatGPT

Attention, la discussion a l’air de se calmer un peu, après une période agressive, mais je rappelle deux points inadmissibles :

- Les discussions sur ChatGPT ont une fâcheuse tendance à se transformer en échange de critiques personnelles réciproques.

- Ces discussions ne doivent plus avoir pour objet de faire une collection des erreurs ou insuffisances de l’outil, surtout quand on l’emploie dans des questionnements tordus qui ne se posent jamais dans la vie réelle : de multiples exemples ont déjà été fournis et OpenAI reconnaît sans problème que ChatGPT, même dans sa version 4 est sujet à des erreurs voire à des "hallucinations". Donc inutile de revenir sur ces points ; c’est du radotage.

En conséquence, ou bien chacun se comporte en respectant ces règles, ou bien la discussion risque de faire long feu.Rien ne sert de penser, il faut réfléchir avant - Pierre Dac

- 29/03/2023, 16h40 #86Archi3

- Date d'inscription

- novembre 2011

- Messages

- 6 706

Re : Petite réflexion sur l'IA et l'usage des outils comme ChatGPT

le but de la comparaison n'était pas de dire que chatGPT pouvait remplacer un avocat, j'aurais aussi bien pu prendre un livreur de pizza qui se trompe 20 % du temps dans la pizza qu'on a commandé, ce n'est pas pour dire que chatGPT peut faire des pizzas.

C'était juste pour interroger le critère de savoir quand est ce qu'on est satisfait ou pas d'un service rendu (surtout quand on le paie, ce qui n'est pas le cas de la version gratuite, mais ça l'est de GPT-4).

Si personne n'essaie les tests que j'ai proposé, je vais quand meme payer mon écot pour le savoir, parce que ça titille ma curiosité

- 29/03/2023, 16h48 #87vgondr98

- Date d'inscription

- septembre 2014

- Messages

- 283

Re : Petite réflexion sur l'IA et l'usage des outils comme ChatGPT

Tu peux les tester sur bing GPT (https://www.zdnet.fr/actualites/vous...t-39955536.htm)

- 29/03/2023, 17h49 #88Archi3

- Date d'inscription

- novembre 2011

- Messages

- 6 706

Re : Petite réflexion sur l'IA et l'usage des outils comme ChatGPT

encore faut il qu'il l'ait "acquis", ce qui implique qu'il ne dira jamais quelque chose de contradictoire. C'est là tout le problème. Les exemples que j'ai donné par ailleurs sont justement intrigants parce que tu lui poses une question, il te répond quelque chose de correct, que tu interprètes par le fait qu'il "sait" quelque chose (parce que toi tu ne pourrais pas répondre si tu ne savais pas ça) , et juste après il te répond autre chose qui est totalement incompatible avec le fait qu'il "sait" cette chose (parce que toi tu ne répondrais jamais ça si tu savais ça).

Ca rend la notion de "savoir" très différente de celle d'un humain - tout simplement parce que ce n'est pas celui d'un humain. Il n'y a pas de perception d'une réalité sous jacente. Il y a des règles probabilistes qui sont optimisées pour donner des réponses aussi justes que possible, mais avec des possibilités d'erreur qu'il serait impossible à commettre si il "savait" que (par exemple une vache est un mammifère).

C'est d'en parler en langage humain (connaissances, savoir, se tromper, etc ...) qui est mal adapté.

- 29/03/2023, 17h50 #89Archi3

- Date d'inscription

- novembre 2011

- Messages

- 6 706

Re : Petite réflexion sur l'IA et l'usage des outils comme ChatGPT

merci - j'ai pas windowsTu peux les tester sur bing GPT (https://www.zdnet.fr/actualites/vous...t-39955536.htm)

- 29/03/2023, 18h47 #90polo974

- Date d'inscription

- février 2007

- Messages

- 9 726

Discussions similaires

-

Science Po vient d'interdire l'usage de Chatgpt, et après ?

Par sunyata dans le forum Discussions scientifiquesRéponses: 133Dernier message: 01/02/2023, 10h27 -

Usage de la balance du watt comme étalon

Par invité576543 dans le forum PhysiqueRéponses: 4Dernier message: 20/06/2013, 15h47 -

Petite reflexion

Par invitedc7f88e0 dans le forum PhysiqueRéponses: 3Dernier message: 25/05/2013, 11h19 -

petite réflexion

Par invitea2b15837 dans le forum PhysiqueRéponses: 5Dernier message: 17/08/2004, 22h24

Fuseau horaire GMT +1. Il est actuellement 05h16.