J'ouvre ce fil afin de pouvoir continuer une discussion très intéressante avec Yves95210 sur le terme de courbure qui intervient dans les équations de Friedmann ainsi que dans la métrique.

Durant mes études, le terme de courbure m'était systématiquement présenté dans sa version réduite, ce qui est très utile au moment d'écrire la métrique (k=-1,0,+1). Cependant, cela a introduit une grande incompréhension chez moi au moment de traiter ce même terme de courbure dans l'equation de Friedmann.

Durant cette discussion plusieurs points sont apparus auzquels je commence a répondre ici et qui vont donc donner la base pour continuer notre discussion.

Tout a fait d'accord, pas mal de gens travaillent sur les conséquences d'utiliser des métriques plus complexes qui peuvent prendre en compte des inhomogénéités locales (LTB en premier lieu). Dans l'absolu c'est une horreur a mettre en place pour beaucoup de choses, mais pour comprendre des observations qui peuvent être affectées par des effets locaux hinomogènes et anisotropiques ça peut être très important. Je pense en particulier a la crise de H0 entre les observations directes et celles qui viennent du CMB et des BAO.Et pour l'appliquer à l'intérieur d'une sphère sans se soucier de ce qui se passe à l'extérieur il faut quand-même faire des hypothèses simplificatrices (en gros, supposer que la symétrie sphérique se prolonge suffisamment loin au-delà de la sphère concernée). Par exemple l'approximation par FLRW marche bien pour la partie centrale des vides cosmiques. Pour les grandes zones de sur-densité (dont certaines parties ont commencé à se contracter, ou ont même fini de le faire, produisant les amas de galaxies) on ne peut utiliser FLRW que pour décrire leur géométrie moyenne, comme tu le dis ensuite; mais effectivement, ça peut suffire en cosmologie (même si il y a encore des débats ouverts sur le sujet)

LTB est effectivement le nom correcte de la métrique. Je pense qu'inconsciemment j'ai tendance a retirer Lemaitre vu qu'il est de toutes les métriques en cosmologieon ne va pas refaire l'histoire, mais Lemaître avait décrit cette solution indépendamment de Tolman (et les deux bien avant que Bondi revisite leurs travaux). Et la métrique est d'ailleurs plutôt connue sous le nom LTB, du moins c'est sous ce nom que je l'ai rencontrée le plus souvent.

il n'y a pas de coquille dans l'équation II.30 du document sur la formation des amas (voir fichier joint que je remets ici), mais bien une erreur (plus qu'une coquille) dans mon message quand j'ai écris que:Tu as dû faire une coquille, puisque (en considérant que est la densité d'énergie totale)

ce qui est incorrecte en effet.

Je voulais me référer au terme général de la courbure comme il est écrit dans Gunn & Gott 1972 (equation 7 du papier https://articles.adsabs.harvard.edu/...pJ...176....1G), en explicitant maladroitement que le terme de droite est la densité d'énergie liée a la courbure on obtient et de l'avoir écrit ainsi. C'était une erreur de l'écrire comme je l'ai fait.

Je dois également préciser que dans le cadre du papier, la densité d'énergie est complètement dominé par la matière, raison pour laquelle le termeréfère a la matiere et comme tu le mentionnais dans ta réponse il est équivalent a

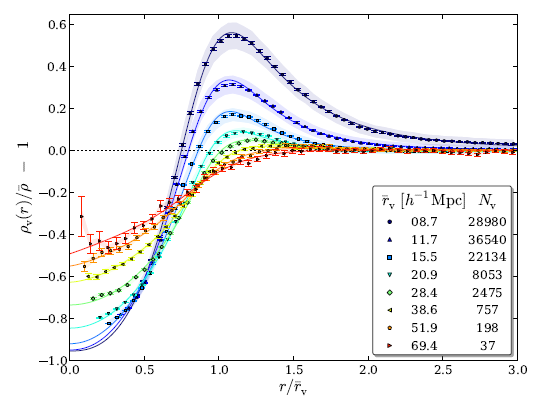

Je pense qu'on peut aussi continuer la discussion sur l'implicaion sur la formation des structures. Comme je le mentionnait, le fait d'appliquer les équations de Friedmann (et donc aussi la metrique FLRW) a des spheres ou ellipses de tailles variable est à la base de la théorie de la formation des structures. Les zones avec une densité plus grande que la densité critique (donc dans le cas d'un univers plat, toutes les sur-densités) ont un terme de courbure positif qui décroit avec le carré du facteur d'échelle tandisque que le terme de densité de la matière décroit comme le cube du facteur d'échelle. Ainsi, le terme de courbure finira par dominer et inverser l'évolution du facteur d'échelle locale (Turn-around) qui collapsera jusqu'a la virialisation du halo (et le facteur d'échelle disparait alors, il est tombé a 0). C'est dailleurs pour cela qu'il n'y a pas d'expansion à l'intérieur des structures collapsées et donc pas dans les galaxies ou les amas de galaxies. Dans un cas très particulier, sans vitesses initiales des particules, tu peut aussi former un trou noir au lieu d'arriver a la virialisation (formation hypothétique des trous noirs primordiaux).

Voila, j'espere ne pas avoir oublié trop de choses pour initier de nouveau cette discussion.

-----

)

)