Hello !

Je sais que la qualité d'une mise à la terre se mesure avec un appareil spécial (telluromètre), hors de portée de bourse des particuliers, mais peut-on à l'aide d'un voltmètre numérique ordinaire tirer quelques conclusions sur la qualité de la mise à la terre d'une installation domestique ?

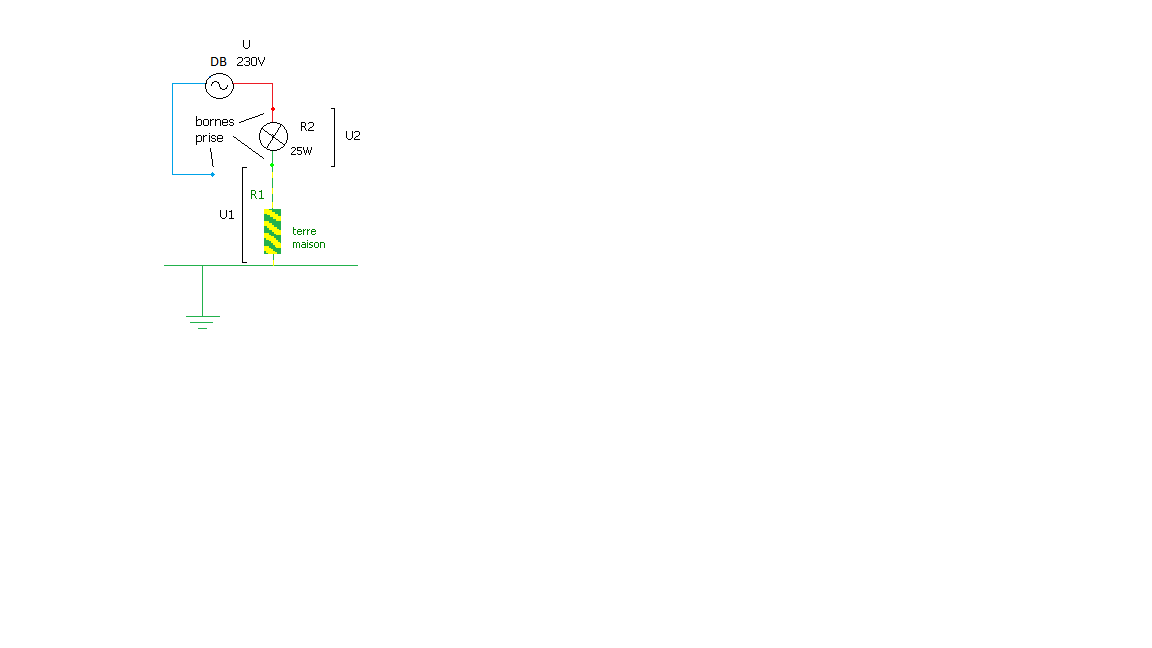

Je m'explique: par exemple, si on mesure sur une prise une ddp aux bornes d'une résistance R1 reliant Phase et Terre < ddp entre Phase et Neutre (proche de 230V), on est sûr que la mise à la terre est de qualité moyenne car sa résistance est élevée, non ?

Plus la résistance du circuit de mise à la terre est élevée, plus on s'éloigne de 230V (principe du diviseur de tension), non ?

http://crteknologies.fr/electronique/cours/bases.php

Us / Ue = R1 / (R1 + R2)

R1: résistance intercalée entre phase et terre (ex.:1400 Ohms pour que I<500ma du disjoncteur différentiel)

R2: résistance circuit de mise à terre

Normalement, Us=Ue=230V, cas idéal où R2=0 (mise à la terre parfaite)

Dès que R2>0, Us < 230V

Si R2 est très faible, l'écart entre Us et Ue est imperceptible.

Exemples

Si R=1400 Ohms et R2=70 Ohms

Us= 1400/(1400+70)x230= 219V

Si R=1400 Ohms et R2=10 Ohms

Us=228V

Si R=1400 Ohms et R2=200 Ohms

Us=201V

A l'inverse, pourquoi si on obtient une ddp aux bornes de R1 = 230V ne peut-on pas déduire que la terre est bonne ?

Comment peut-on avoir 230V si la résistance R2 de la mise à la terre est élevée ?

Ce type d'appareil http://www.materielelectrique.com/co...0-p-12072.html ne fonctionne-t-il pas sur ce principe ?

Par avance, merci de m'éclairer sur ces différents points.

@+

Zebulon.

-----

Heu... en installation domestique, en France, le régime de neutre est TT donc Neutre=Terre, non ?

Heu... en installation domestique, en France, le régime de neutre est TT donc Neutre=Terre, non ?

:

:

?

?